В попередній статті «Як додати сайт до пошукових систем» ми розповіли, як повідомити пошукових роботів про новий сайт або сторінки. Але після додавання сайту до пошукових систем він все ще може не індексуватися в Google. Що ще гірше, пошукові роботи сканували сайт раніше, але тепер сайт не індексується.

Єдиний вихід у цій ситуації — перевірити можливі причини, що впливають на індексацію сайту. Про ці причини розповімо у статті.

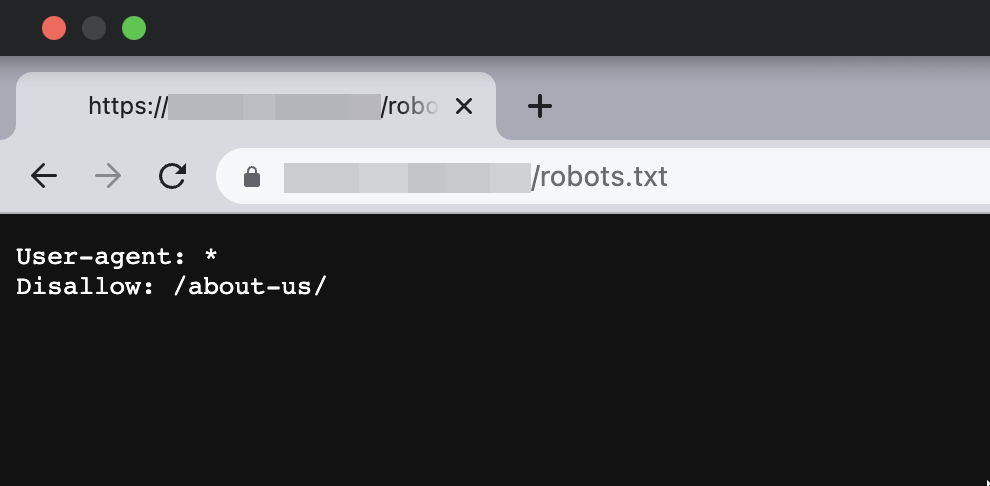

Сайт закритий від індексації у Robots.txt

Одна з найпоширеніших причин, через яку сайт не індексується — заборона на індексацію у файлі robots.txt. Часто розробники сайту зберігають тестову версію на окремих доменах чи піддоменах. Тестовий сайт закривають від індексації за допомогою robots.txt. Коли сайт вже готовий, вміст тестової версії разом із файлом robots.txt потрапляє на робочий домен. Файл robots.txt забувають змінити і сайт стає недоступним для пошукових роботів.

Файл robots.txt знаходиться в кореневій папці сайту — https://mysupersite.com/robots.txt

Якщо сторінку закрито від індексації, вміст файлу може виглядати так:

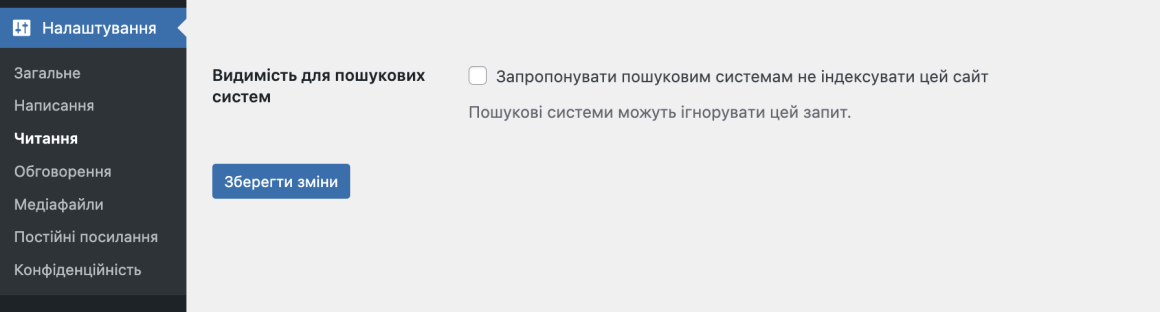

Якщо у вас сайт на CMS WordPress, перевірте налаштування індексації в панелі керування сайтом. Зайдіть у розділ Налаштування → Читання. Поле Видимість для пошукових систем має бути порожнім:

Як перевірити Robots.txt

За допомогою наступних інструментів можна перевірити, чи не закрито через robots.txt від індексації сайт або певні сторінки:

- Інструменти перевірки robots.txt

Попередньо потрібно додати сайт до панелі вебмайстрів Google, щоб перевірити robots.

👉 Для перевірки також можна скористатися сторонніми сервісами, наприклад

- https://technicalseo.com/tools/robots-txt/

- https://sitechecker.pro/robots-tester/

- https://www.websiteplanet.com/uk/webtools/robots-txt/

- Інструменти для вебмайстрів

Якщо ще не користуєтеся цими сервісами, читайте статтю: Як додати сайт до інструментів вебмайстрів.

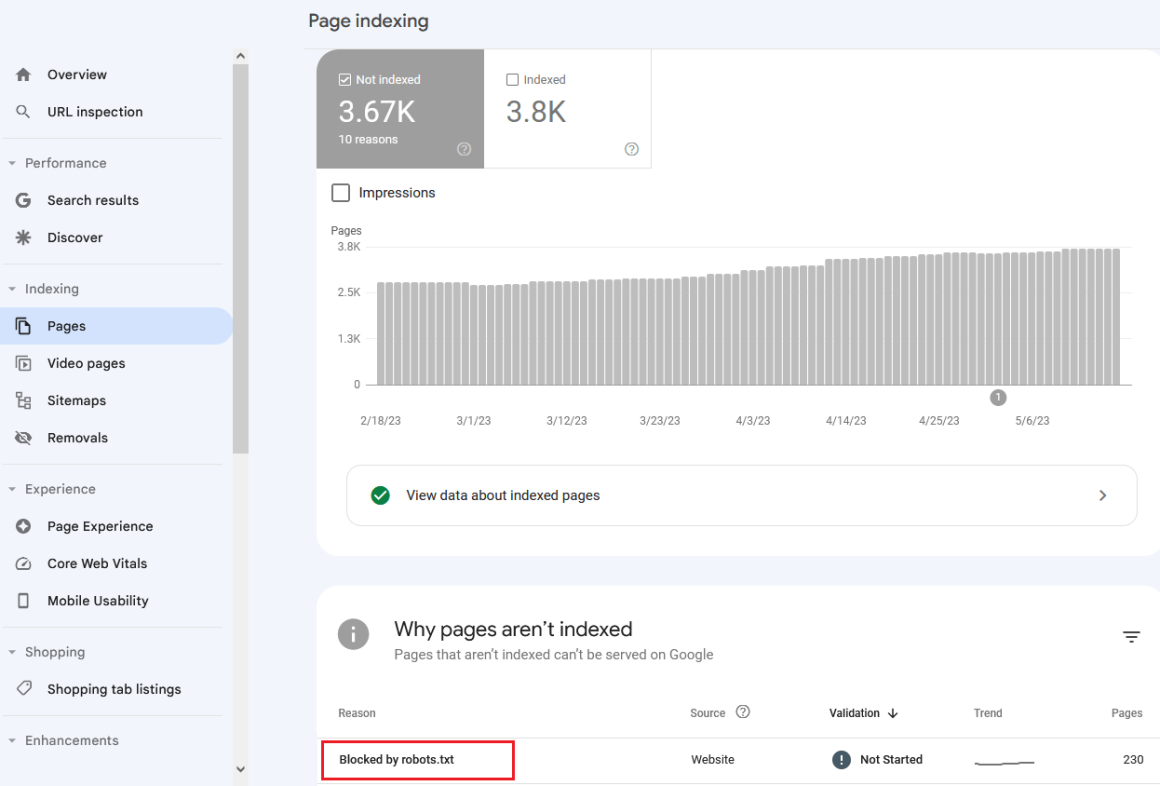

У Google Search Console перейдіть до розділу Індексування → Сторінки → таблиця Чому ці сторінки не індексуються .

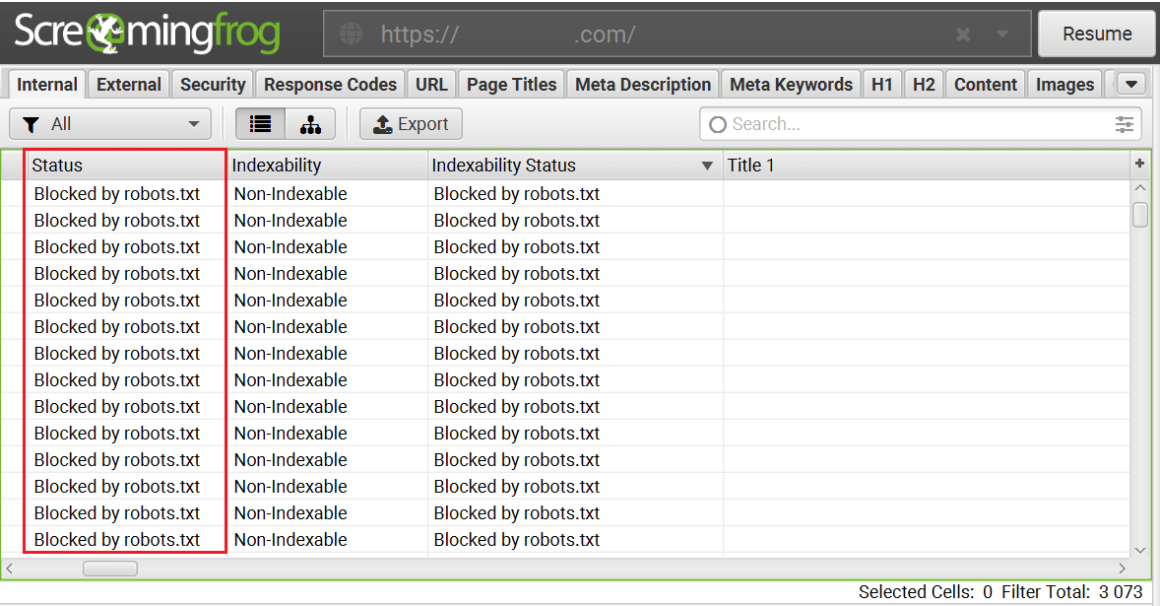

- Програми для аудиту внутрішньої оптимізації сайту

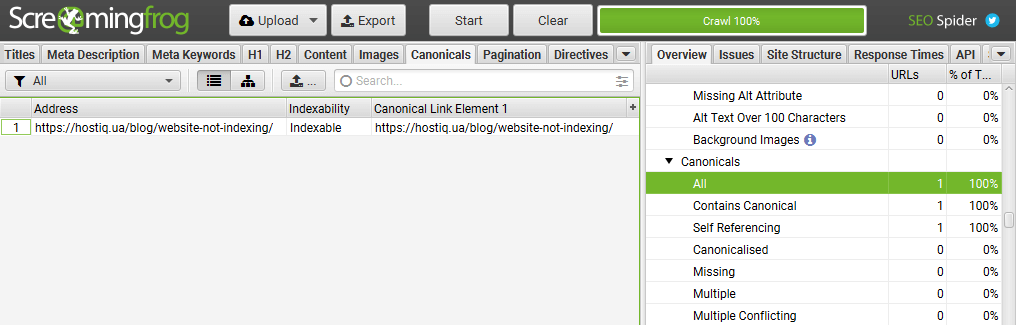

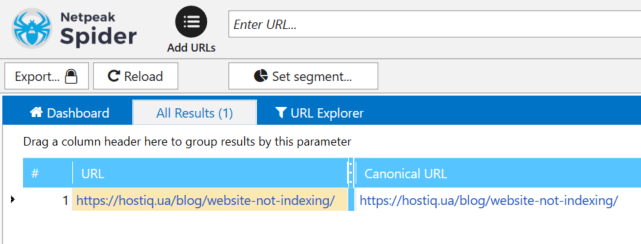

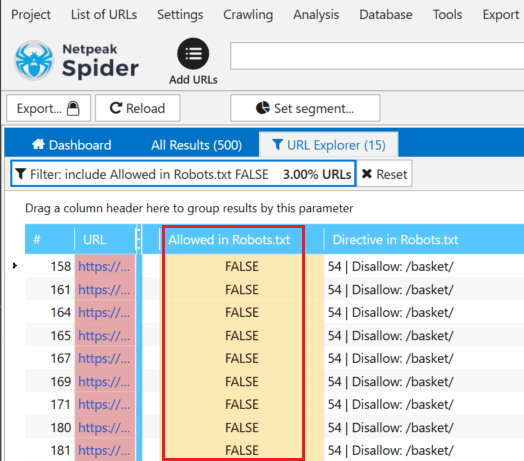

Після сканування сайту або певних сторінок, у результатах звіту будуть показані сторінки, які недоступні для індексації:

Screaming Frog SEO Spider

Netpeak Spider

Читайте також: SEO-сервіси для аналізу та перевірки сайту

Метатеги Robots

Перевірте наявність метатегу robots у коді сторінки. Його розміщують між тегами <head></head>. Виглядати цей тег може так:

<meta name=“robots” content=“noindex”>Метатег robots повідомляє пошукові роботи про те, що сторінку індексувати не потрібно.

Як перевірити метатеги Robots

- Інструменти для вебмайстрів

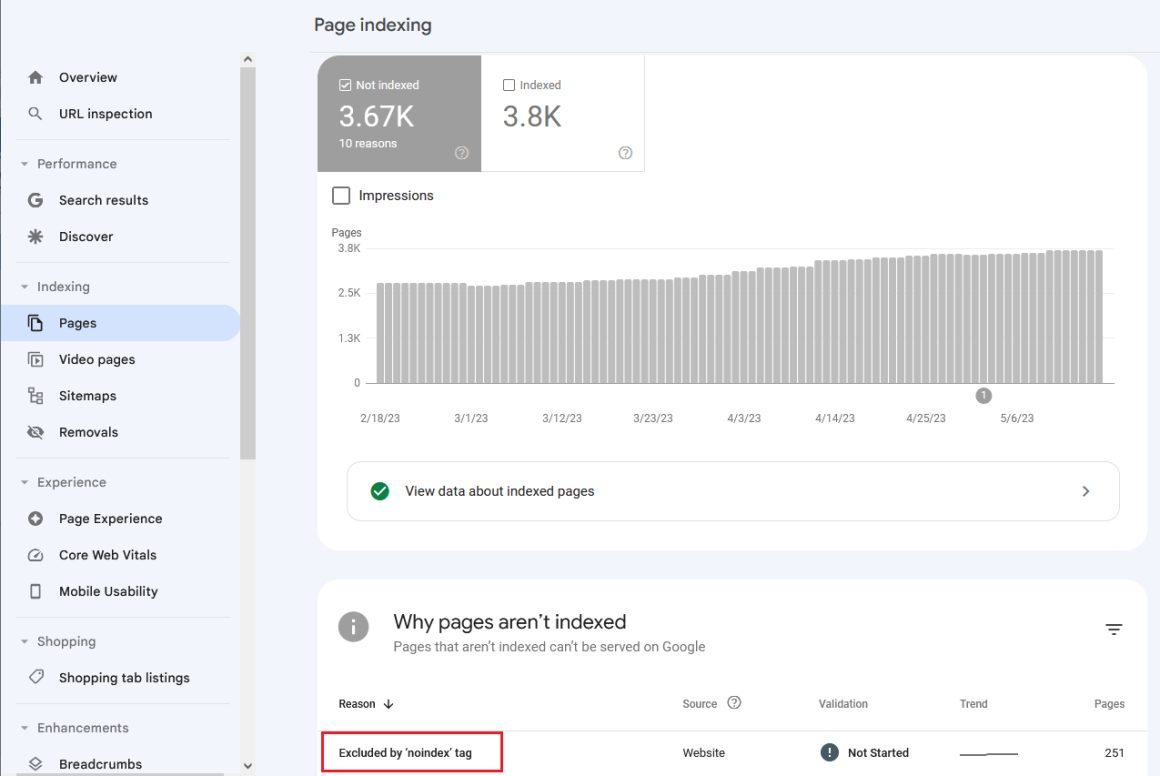

У Google Search Console перейдіть до розділу Індексування → Сторінки → таблиця Чому ці сторінки не індексуються.

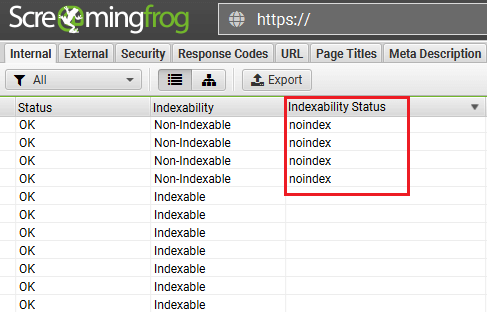

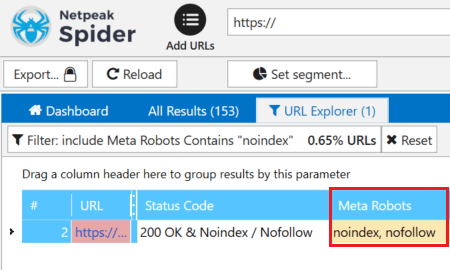

- Програми для аудиту внутрішньої оптимізації сайту

Виявити сторінки, які закриті від індексації за допомогою метатегів robots, можна за допомогою програм для аудиту внутрішньої оптимізації сайту.

Screaming Frog SEO Spider

Netpeak Spider

При купівлі на рік — знижка 20%

Файл .htaccess

Файл .htaccess містить правила роботи вебсервера. Зазвичай цей файл розміщують у кореневій директорії вебсервера (/public_html) або кореневої директорії сайту (/public_html/mysupersite.com/).

За допомогою деяких правил .htaccess можна закрити сайт від індексації. Наприклад, можна закрити доступ для всіх відвідувачів, крім потрібної IP-адреси:

order allow,deny

deny from all

allow from IPАбо можна дозволити доступ всім, крім потрібного IP:

order allow,deny

deny from UndesiredIP

allow from allПеревірте файл .htaccess на вашому сервері, можливо в ньому прописані заборонні правила для індексування.

Докладніше дізнатися про директиви та правила можна у нашій статті: Файл htaccess.

Rel Canonical

Тег rel=”canonical” застосовують на сторінках з однаковим вмістом. Цей тег вказує пошуковим роботам адресу сторінки, яка є основною.

Розглянемо на прикладі дві сторінки, які мають однаковий зміст:

- https://mysupersite.com/original-page/ — основна сторінка;

- https://mysupersite.com/dublicat-page/ — сторінка з дублюючим змістом.

Щоб в індексі була основна сторінка, можна застосувати тег rel=”canonical”. У html код сторінки https://mysupersite.com/dublicat-page/ між тегами <head></head> потрібно додати наступний тег:

<link rel="canonical" href="https://mysupersite.com/original-page/" />Якщо ваша сторінка або сторінки не індексуються, перевірте наявність тега rel=”canonical” у html-коді та його коректність.

Стаття з теми:

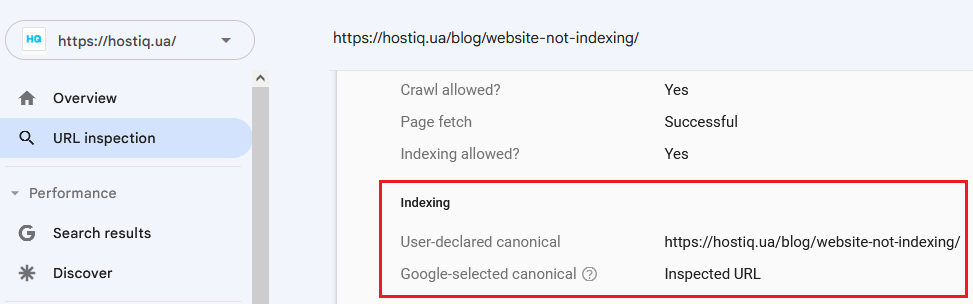

Як перевірити наявність тегів rel=”canonical”

- Google Search Console у розділі Перевірка URL.

- Screaming Frog, Netpeak Spider або інші подібні програми

X-Robots-Tag

X‑Robots-Tag ― це директива у заголовках відповіді сервера, за допомогою якої можна заборонити роботам індексувати конкретні сторінки чи файли. Приклад HTTP-відповіді сервера з директивою X-Robots-Tag, яка забороняє індексацію сторінки:

HTTP/1.1 200 OK

Date: Tue, 19 May 2020 22:34:11 GMT

(…)

X-Robots-Tag: noindex

(…)Цей тег можна використовувати у конфігурації сервера. На серверах Apache він додається у файл .htaccess, на серверах Nginx у файл conf.

Розглянемо на прикладі, як виглядає заборона на індексацію файлів .doc через X-Robots-Tag:

Фрагмент коду у файлі .htaccess для сервера Apache

<Files ~ "\.doc$">

Header set X-Robots-Tag "noindex, nofollow"

</Files>Фрагмент коду у файлі conf для сервера Nginx

location ~* \.doc$ {

add_header X-Robots-Tag "noindex, nofollow";

}Додаткову інформацію про цей заголовок HTTP можна отримати у довідці Google.

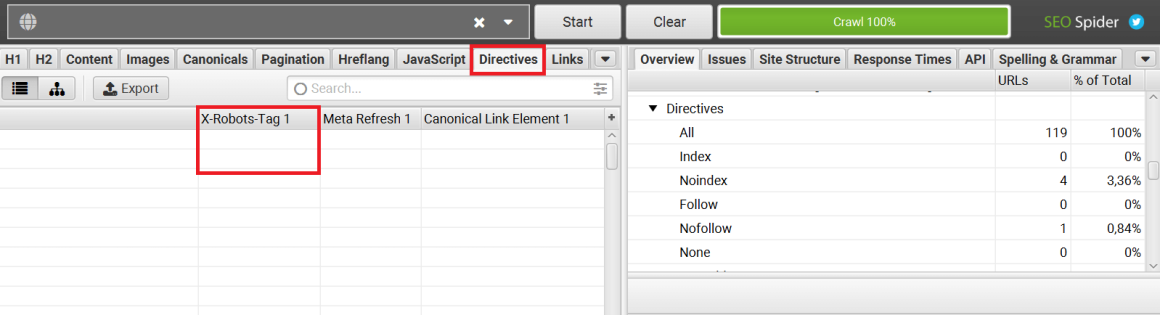

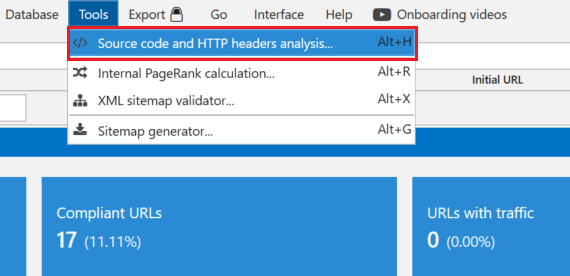

Як перевірити наявність X‑Robots-Tag на сторінках сайту

Плагін Web Developer для браузерів:

Сервіси чи програми для аудиту сайту — Screaming Frog, Netpeak Spider та інші аналоги:

Довга відповідь сервера

Час відповіді сервера — це час, за який запит клієнта в браузері доходить до сервера і клієнт отримує відповідь сервера. Час відповіді вимірюється в TTFB (Time To First Byte) — час до першого байта, або скільки мілісекунд пройшло між вашим запитом та відповіддю сервера. Google рекомендує прагнути, щоб час відгуку був менше 200 мілісекунд. TTFB більше 500 мс вже є проблемою.

Якщо при зверненні пошукового робота до сервера він отримує довгу відповідь, то робот може не просканувати частину сторінок.

Як перевірити час відповіді сервера

Перевірити час відповіді сервера можна за допомогою сервісів:

Стаття з теми:

Можливі причини тривалої відповіді сервера

Серед можливих причин можна виділити такі:

- недостатній обсяг ресурсів сервера: слабкий процесор, недостатньо пам’яті;

- не оптимізовано роботу сервера;

- відсутність оптимізації швидкості завантаження сайту. Не мінімізовані файли CSS/JS, не стиснуті зображення тощо.

- відсутність кешування.

Якщо ви оптимізували швидкість завантаження сайту, але у вас залишилися проблеми з довгою відповіддю сервера, варто спробувати інші хостинги. Наприклад, ми пропонуємо віртуальний хостинг із серверами в Україні, Нідерландах та США.

Ваш сайт більш вимогливий і потрібно більше потужностей? Не проблема. У нас є VIP пакети з великим обсягом ресурсів або можна взяти VPS.

Візьміть хостинг на тест та перевірте самі. 30 днів безплатно! 🔥

Спробуйте швидкий хостинг на чистих SSD-дисках!

Наша тепла підтримка на зв’язку 24/7

Невірна відповідь сервера

Перевірте код відповіді сервера. Переконайтеся, що потрібні сторінки віддають код 200. Цей код означає, що сторінка доступна на сервері.

Як перевірити відповідь сервера

Перевірити відповідь сервера можна за допомогою інструментів:

- Google Search console

- httpstatus.io

- Netpeak Spider, Screaming Frog або інші програми.

Також можна використовувати різні плагіни для браузерів або можна перевірити у самому браузері ― F12+вкладка Network.

Неякісний контент

Якщо ваші сторінки містять контент, який не має цінності для користувача, пошукові роботи можуть не індексувати їх. В англомовних статтях можна зустріти термін thin content, який описує дані сторінки.

Прикладом такого контенту може бути:

- дубльований контент;

- скопійований контент;

- автоматично згенерований контент;

- неінформативні сторінки із партнерськими посиланнями;

- дорвеї .

Докладніше про опис неякісного контенту та рекомендації для вебмайстрів можна прочитати в довідці Google.

Проблеми на боці пошукових систем

Як то кажуть — кінь на чотирьох ногах, та й то спотикається. На боці пошукових систем теж можуть виникати проблеми. Наприклад, у середині липня 2022 року у Google виникли проблеми з індексацією нового контенту. Про це можна прочитати в новині Google confirmed indexing issue affecting a large number of sites.

На такі проблеми в Google оперативно реагують та виправляють їх.

Коротко: чому сторінки сайту не індексуються в Google

Підсумуємо причини, через які сторінки сайту можуть не індексуватися:

- Сайт закритий від індексації через

- robots.txt

- метатеги robots

- файл .htaccess

- X-robots-tag

- Помилки в rel canonical

- Довга відповідь сервера, проблеми з хостингом

- Невірна відповідь сервера

- Неякісний контент

- Проблеми на боці пошукових систем

Для зручності зібрали всі пункти та рекомендації в чек-лист: чому сторінка не ранжується в Google.

Пишіть у коментарях, на яку SEO-тему хочете бачити наступні статті 💬